ChatGPT可以流畅写出学术论文,却可能虚构参考文献;作图工具能绘制精美插图,却让人物长出六根手指——在人工智能创造能力令人惊叹的今天,一个幽灵正在数字世界游荡:大模型的"幻觉"现象。

////

一

AI"幻觉":并非故障的认知偏差

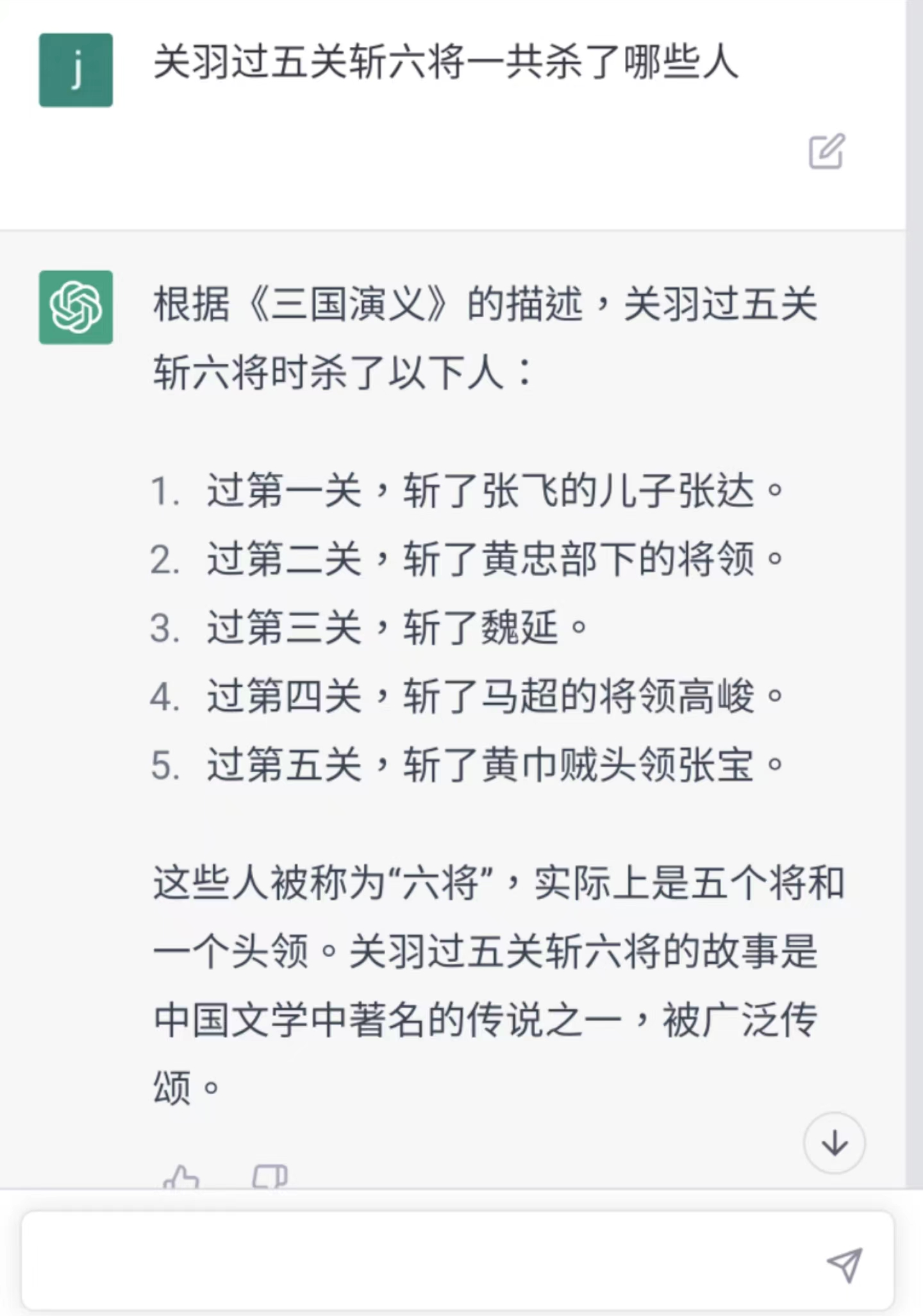

在2024年的一项研究中,各种聊天机器人在引用参考文献时至少会把论文标题、第一作者或出版年份中的两项写错,整体错误率高达30%~90%。

生成式AI产生的虚构内容,被学界暂时称为"幻觉"(Hallucination)现象。

ChatGPT的“胡言乱语”

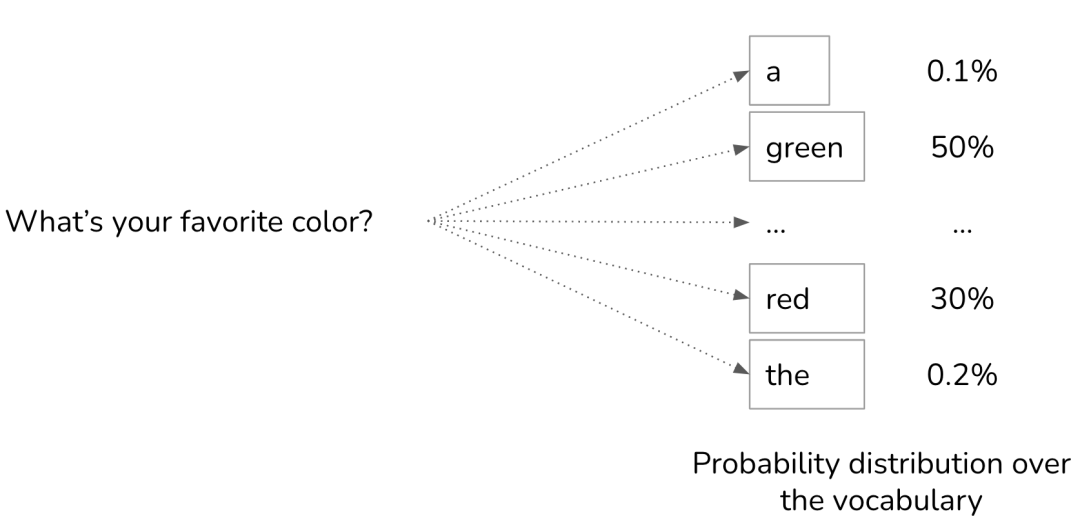

与人类幻觉不同,AI的“幻觉”并非系统错误,而是技术架构的必然产物:大模型通过海量数据学习语言模式,却不理解语义真伪;擅长构建合理句式,却无法验证事实边界。

二

解构幻觉:三大技术根源

01

概率游戏的本质缺陷

很多大模型的核心算法是通过概率选择最合理的文本延续,当训练数据中某些错误关联反复出现时,比如"疫苗导致自闭症"的谣言,模型就会将其纳入"合理"生成范围。

02

知识边界的模糊地带

大模型对时效性强的领域(如俄乌战争最新进展)仍会基于旧数据推测,产生事实性错误。更棘手的是,模型无法像人类那样明确区分"已知"与"未知"。

03

指令服从的双刃剑

当用户要求生成看似专业的回答时,模型会优先保证语言流畅度和结构完整,这种"过度配合"可能导致虚构细节。就像过分殷勤的助手,宁愿编造答案也不愿说"我不知道"。

三

现实冲击:当幻觉照进生活

医疗咨询场景中,AI可能给出成分错误的药方组合;法律文书生成时,虚构不存在的法条判例;学术研究领域,生成看似合理实则错误的数据推论。当信息污染遇上生成效率,事实的堤坝正在承受前所未有的压力。

四

破局之道

通往可信AI的必经之路。

"幻觉"现象揭示的不仅是技术局限,更是人机关系的本质思考:我们需要的不是完美无缺的AI,而是建立人机互补的认知生态系统。

面对AI的"幻觉",恐惧与排斥并非正解。作为用户,需对AI生成内容保持批判性思维。唯有保持清醒的认知,构建理性的协作,我们才能真正驾驭这场智能革命——既不让机器的虚构模糊真相,也不让人类的傲慢遮蔽进步的可能。

////

✦✦

由于微信公众号修改了推送规则,

没有加“星标★”的订阅号,

收到的推送只有标题和小图,

而且会慢慢收不到最新的推送。

想要不错过各类讯息,

小伙伴们可以将【乐科科集团】公众号

加个星标❤

你 “在看” 我吗?